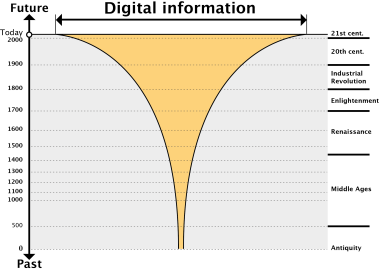

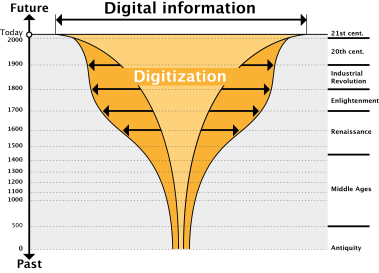

Première ébauche d’un texte pour le catalogue d’une exposition au Quai Branly. Un travail réalisé avec un de mes doctorants Dana Kianfar, qui travaille sur les algorithmes et le capitalisme linguistique. Les questions plus générale sur les effets de la médiation algorithmiques sur la langue ont été traitée dans Kaplan (2014) et la transformation progressive des livres en machines, thème connexe à celui traité ici est discutée dans Kaplan (2012). Le billet prolonge le travail pionnier de Stuart Geiger dans ce domaine (Geiger 2011). J’ai également parlé de ce sujet sur la RTS 1 lors d’une interview de 10 min à l’émission CQFD.

16 des 20 contributeurs les plus actifs sur la version anglaise de Wikipedia sont des bots. Cette estimation, a peu près équivalente à celle de Stuart Geiger en 2011, est rapidement obtenue en comparant la page qui classe les contributeurs humains le plus prolifiques avec celle qui propose le même classement pour les algorithmes. Dans ce classement qui mesure l’activité par le nombre d’actions d’édition sur l’encyclopédie en ligne, le premier contributeur humain n’arrive qu’à la douzième position. Ce chiffre varie selon les communautés linguistiques de Wikipedia. Dans le même classement pour la version espagnole de Wikipedia, on ne retrouve que deux bots.

Wikipédia n’est pas simplement le grand oeuvre d’une communauté d’utilisateurs qui, ensemble, aurait décidé de construire une encyclopédie libre et gratuite. C’est aussi le résultat du travail de plusieurs centaines d’algorithmes qui chaque jour mettent en forme, contrôlent, surveillent et réprimandent les contenus écrits. Au fil des années, les hommes ont appris à construire et structurer la connaissance en programmant des règles que les bots se chargeaient d’appliquer. Les bots ont aidé à construire Wikipedia et aujourd’hui, jouent un rôle crucial dans sa maintenance et son évolution. Ce faisant il sont devenus comme une présence, une altérité machinique que les contributeurs de l’encyclopédie en ligne ont accepté avec plus ou moins de facilité. L’histoire de ces premières frictions, la négociation progressive de l’autonomie accordée à ces algorithmes sont les prémisses d’un monde qui vient, où hommes et machines devront apprendre à partager un même espace pour écrire ensemble.

Historiquement,les bots ont joué un rôle important dans la création et le développement de Wikipédia. En février 2002, plusieurs centaines d’articles du « Federal Standard 1037c », un dictionnaire de termes techniques, ont été importés et wikifiés par un algorithme, proposant ainsi la base de nombreuses nouvelles pages que les utilisateurs que les utilisateurs purent ensuite enrichir. À la même période, de nombreux articles du « Easton’s Bible Dictionary », un ouvrage de la fin du XIXe siècle, furent également importés et restructurés pour servir de contenu initial à des pages Wikipedia encore inexistantes. Cette importation a conduit à introduire dans certaines pages de Wikipedia une prose victorienne anachronique, qui fut progressivement assimilée pour se fondre avec l’anglais contemporain. Le même bot importa une grande partie des articles de la version de 1911 de l’Encyclopedia Britanica, à partir d’une copie numérisée par le projet Gutenberg.

Durant ces premières années, les algorithmes se nourrissant des contenus suffisamment anciens pour être passés dans le domaine public ont ainsi contribué à structurer les premiers contenus de Wikipedia lui permettant d’atteindre rapidement une masse critique. Dès que la logique de « template » pouvait être appliquée, des bots ont été utilisés pour produire des articles types. Un algorithme nommé « Ram-bot » produisit ainsi les articles de base pour 30 000 villes américaines en important les données du recensement américain et en les structurant dans un style simple et systématique. Ce squelette textuel fut ensuite étoffé par les contributeurs qui l’enrichirent avec des détails de la géographie et l’histoire locale de chaque ville, expérimentant sans vraiment en avoir conscience une forme d’écriture mixte personne-machine.

Ce procédé fut répété à plusieurs reprises, mais toujours dans des domaines de la connaissance de plus en plus pointus. En 2008, par exemple, un algorithme nommé « Clue-bot II » créa 15 000 petits articles sur les astéroïdes à partir d’une base de données de la Nasa. Ces articles furent à leur tour édités puis traduits par d’autres bots. Malheureusement, la base, assez ancienne, contenait des erreurs et, quand un humain a réalisé la contamination, un processus de correction massive dut être mis en place. Ce type d’accidents a contribué à alimenter la polémique autour des bots et leur rôle positif ou négatif sur la construction et la régulation de l’encyclopédie en ligne.

Aujourd’hui les bots assurent de nombreuses fonctions de maintenance et de réparation, souvent répétitives et consommatrices de temps. Un des algorithmes patrouilleurs les plus sophistiqués s’appelle ClueBot NG. Il identifie et répare les actes de vandalisme, comme l’insertion de propos outrancier sans rapport avec le contenu d’une page donnée. D’autres bots détectent des violations possibles de copyright, tissent des liens entre les pages de différentes versions linguistiques de Wikipédia, bloquent automatiquement les pages qui sont modifiées avec trop d’intensité, corrigent les fautes de syntaxe et d’une manière générale se chargent d’automatiser les règles et normes de bon fonctionnement de l’encyclopédie en ligne. La version anglaise de Wikipédia comptant plus de 4 millions d’articles, dont une partie significative sont régulièrement mis à jour, seule une police algorithmique semble pouvoir veiller sur cet édifice en perpétuelle reconstruction. C’est ce qui a poussé certains éditeurs de Wikipédia à devenir programmateurs de bots, les concevant avant tout comme une forme d’outil d’édition puissant. Ce faisant, ils ont donné naissance à un écosystème complexe, conduisant à des articles systématiquement coproduits par des humains et des machines.

L’ambivalence des bots réside dans leur double nature, à la fois la formalisation informatique d’une règle de comportement et l’agent faisant appliquer cette règle. Une des controverses la plus importantes dans la longue histoire de la négociation de la présence des bots sur Wikipédia est relatée par Stuart Geiger (2011). L’algorithme Hagermanbot ne faisait qu’appliquer une règle acceptée sur Wikipédia. Il identifiait les commentaires sans signature et ajoutait automatiquement l’identité de leur auteur. Personne ne remettait en cause cette règle, mais quand elle fut appliquée systématiquement par l’algorithme, l’action du bot fut perçue comme embarrassante pour certains. Il existait des situations dans lesquelles un auteur pouvait vouloir différer sa signature ou effectivement laisser son commentaire non signé. Certains argumentèrent que la règle des signatures n’était qu’une « guideline » pas une loi dont l’application devait être systématiquement vérifiée par la surveillance policière et violente d’un algorithme.

C’est la différence, discutée par Bruno Latour, entre le gendarme et le « gendarme couché ». Le premier fait appliquer la limitation de vitesse dans une rue à proximité d’une école, mais sait en adapter l’application quand une ambulance doit exceptionnellement passer par ce chemin. Le « gendarme couché », devenu infrastructure urbaine de ralentissement, ne fait pas de distinction et applique la règle communément admise dans tous les contextes, sans discrimination. « Les techniques agissent comme des transformateurs de forme, faisant un policier d’une charge de béton frais, donnant à un gendarme la permanence et l’opiniâtreté de la pierre » (Latour 2001, p.199).

Alors la règle collectivement négociée devient algorithme et que l’algorithme devient agent qui fait systématiquement appliquer la règle, une force hostile semble menacer l’édifice utopique collectivement construit. Poser la question « Les bots de Wikipédia sont-ils méchants » revient à se demander si Wikipédia est l’archétype d’un collectivisme auto-organisé qui fonctionne, un modèle à imiter pour créer demain des sociétés numériques égalitaires créatrices de biens communs ou si elle préfigure au contraire une algorithmisation massive de la société caractérisée par une surveillance permanente et auto-infligée. L’algorithme s’anthropomorphise quand il devient menaçant, même si on le sait non doté d’une quelconque forme d’autonomie. Contrairement au robot humanoïde (Kaplan 2004), il fait peur non pas parce qu’il commence à ressembler à l’humain, mais parce qu’au contraire, il se montre inflexible, aveugle au contexte, et, qu’il ait raison ou qu’il ait tort, capable de soumettre les hommes aux lois qu’ils ont eux-mêmes créés. L’expérience Wikipédia nous invite à penser ces « autres » qui semblent être devenus nos partenaires, amis ou ennemis, pour organiser la connaissance à l’échelle planétaire.

Geiger, R. Stuart. 2011. “The Lives of Bots.” In Critical Point of View: A Wikipedia Reader, 78–93. Institute of Networked Cultures, Amsterdam. http://papers.ssrn.com/sol3/Delivery.cfm?abstractid=2075015#page=41.

Kaplan, Frédéric. 2004. “Who Is Afraid of the Humanoid? Investigating Cultural Differences in the Acceptance of Robots.” International Journal of Humanoid Robotics 01 (03): 465–80. doi:10.1142/S0219843604000289.

Kaplan, Frédéric. 2012. “How Books Will Become Machines.” In Lire Demain. Des Manuscrits Antiques à L’ère Digitale., edited by Claire Clivaz, Jérome Meizos, François Vallotton, and Joseph Verheyden, 25–41. PPUR.

Kaplan, Frederic. 2014. “Linguistic Capitalism and Algorithmic Mediation.” Representations 127 (1): 57–63. doi:10.1525/rep.2014.127.1.57. Latour, Bruno. 2001. L’espoir de Pandore : Pour Une Version Réaliste de L’activité Scientifique. Editions La découverte. https://hal-mines-paristech.archives-ouvertes.fr/hal-00830223.

L’origine médiévale de l’hyperlien, des pointeurs et des smileys

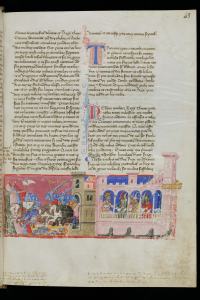

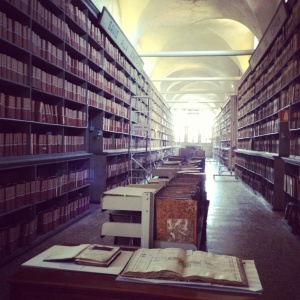

avril 19, 2013Le second manuscrit que nous présentons dans une vitrine à réalité augmentée pour l’exposition « Le lecteur à l’oeuvre » est une copie du XIVe siècle produite à Bologne d’un texte juridique de l’empereur byzantin Justinien Ier. Sa décomposition révèle d’étranges surprises et nous invite, comme pour le Guido delle colonne à un voyage dans le temps. Je me base pour ce billet sur le texte de Valérie Hayaert (à paraitre dans le livre le lecteur à l’oeuvre chez Infolio) qui s’appuie elle-même sur certaines conclusions d’Élisabeth Pellegrin (1982, pp. 195-198.). Et toujours un grand merci à Radu Suciu qui me guide dans la compréhension dans ces mondes des manuscrits médiévaux.

L’empereur Justinien a opéré au VIe siècle un grand travail de réorganisation législative. Au fil des siècles, les différents régimes avaient complexifié le droit romain primitif. Les juristes du Justinien ont procédé à une simplification, une modernisation et une uniformisation du code juridique de l’empire. Ce nouveau code a subsisté pendant de nombreux siècles comme base du droit. La page que nous présentons se présente sous la forme d’une mise en page complexe, comportant de multiples blocs de textes. Le texte juridique de Justinien est au centre de la page, présenté en deux colonnes. Le texte est accompagné de lettrines, mais surtout plusieurs signes qui, dans les marges, viennent aider la lecture.

Pointeurs

En marge de la première colonne, une petite main, ou manicule, a été dessinée pour souligner un passage important.

Ce signe calligraphique était fréquemment utilisé dans les manuscrits au Moyen-âge. Voytek Bialkowski, Christine DeLuca et Kalina Lafreniere proposent dans l’entrée « Manicule » du site Archbook de l’université de Toronto (Merci à Radu Suciu pour le lien) plusieurs exemples de ces petites mains. Ici sur un texte grec.

Là sur une partition

Dans les premières décennies de l’imprimerie, les typographes adaptèrent le signe pour l’inclure dans les nouveaux livres.

Dans tous ces cas, la manicule joue le rôle d’un outil intellectuel qui favorise la mémorisation et aide la lecture du texte.

Au XIXe et XXe siècle, la manicule a été adaptée sous la forme de caractères d’imprimerie standardisés pour la publicité.

Prolongeant la filiation, Bialkowski, DeLuca et Lafreniere considèrent qu’il s’agit de l’ancêtre des pointeurs utilisés dans les interfaces informatiques.

Cette filiation est également discutée par Peter Stallybrass dans son exposé « The Book as Computer » donné à l’Université de South Carolina le 17 avril 2009 (en vidéo ci-dessous). Peter Stallybrass explique en complément que des le moyen-âge des « doigts mobiles », objets physiques déplaçables, ont proliféré permettant aux lettres de tenir des livres ouverts, de pointer certains passages, etc. Stallybrass parle de « prosthetic fingers » offrant littéralement la possibilité d’avoir plus que dix doigts.

Mais face dans cette généalogie, une question de bon sens se pose. William H. Sherman la formule ainsi dans son livre Used Books: Marking Readers in Renaissance England

La manicule médievale, comme celle que nous constatons en marge du texte juridique de Justinien est un donc autant un geste qu’un signe. C’est en particulier une signature personnelle, celle du lecteur, qui prend soin de marquer par de manière distinctive, par un doigt pointé stylisé, sa contribution à cette indexation du texte original. Avec le temps pourtant, elle se standardise, cesse d’être signature pour devenir symbole.

Smileys

En marge de la seconde colonne du texte juridique, un visage de profil est dessiné.

Le copiste a peut-être suggéré qu’il faut marquer ici un temps de réflexion ou éventuellement son désaccord avec le contenu de ce passage. Nous pourrions considérer que ce type de visage est l’ancêtre de nos actuels « smileys ».

Rappelons que la lecture silencieuse n’existait pas à cette époque. Il était alors courant d’ajouter des indications pour guider la gestuelle ou l’intonation de l’orateur. C’est de nouveau un geste de lecture qui a pour fonction de modifier à la fois la perception et l’expression du texte. Le smiley trouve ici son origine dans une technique de l’oralité, dans un contexte où expression orale et art de la mémoire sont intimement associés.

Comme pour les manicules, le smiley fait des apparitions typographiques dans la presse au XIXe siècle par exemple dans ce numero du 30 Mars 1881 de Puck magazine (reproduit dans le livre 100 diagrams that changed the world, Merci à Christophe Guignard pour le lien)

David Crystal dans son analyse de l’utilisation contemporaine des smileys analyse le nouveau rapport à l’oralité que ces signes ont introduit dans le discours écrit (Crystal 2001, p. 38-39). Il est intéressant de voir que ce lien avec l’oralité trouve en fait ses racines dans d’anciennes pratiques médiévales.

Hyperliens

Justinien considère que le nouveau code publié en 533 est parfait et il interdit expressément tout commentaire des nouvelles lois ainsi présentées. Mais malgré l’interdiction, les copistes ont entouré le texte du digeste par les commentaires de François Accurse, grand juriste toscan. Il faut en effet adapter les textes anciens du droit romain à la situation du moyen-âge. François Accurse est d’ailleurs considéré par les Florentins comme un des citoyens les plus illustres. Il a sa statue dans le piazzale des Offices à côté de Dante ou Pétrarque, Boccace ou Amerigo Vespucci. Ses commentaires ont peut-être autant de valeur que le texte de Justinien lui-même.

Les commentaires sont associés au texte principal par un système de renvois basé sur des signes calligraphiques.

.

Beaucoup de signes différents sont utilisés

D’autres lecteurs ont commenté les commentaires de François Accurse, soulignant parfois certains mots. Ils utilisent un second niveau de renvois et écrivent dans les espaces encore vierges de la page. Parfois, un troisième niveau de renvois est présent.

Ce jeu de renvois rappelle le principe contemporain de l’hyperlien. Dans la généalogie « classique » de l’hypertexte, on a coutume de se référer aux travaux de Ted Nelson ou au texte « visionnaire » de Vanevar Bush qui en 1945 dans « As we may think » définissent le principe du fonctionnement du Memex. Des auteurs comme Buckland (1998) se sont attachés à corriger et prolonger cette généalogie officielle en retraçant la lignée technique plus loin jusqu’à Paul Otlet ou jusqu’au bibliothécaire allemand Shuermeyer. Mais il faut évidemment réinscrire la lente conception du principe de textes en réseaux dans une perspective beaucoup plus vaste, qui englobe l’encyclopédisme du XVII et XVIIIe siècle et trouve ses racines dans les nombreux manuscrits qui au moyen-âge développent des outils complexes pour articuler plusieurs niveaux de gloses. Pour reprendre les idées de Pascal Robert (2010), le manuscrit est déjà un volume, un conteneur dont il s’agit d’organiser les circulations. Ici, c’est au niveau de la page, en deux dimensions, que des dispositifs innovants permettant la circulation entre les textes sont mis en place.

Ainsi, pointeurs, smileys et hyperliens sont déjà d’une certaine manière présents dans les manuscrits du XIVe siècle. Ils correspondent à des usages conventionnels que les technologie de l’impression d’abord, puis de l’informatique viendront mécaniser et standardiser. Ce processus de régularisation des représentations régulées que Pascal Robert décrit dans son livre Mnemotechnologies (Robert 2010) et dont j’ai discuté les principes dans un article récent, How books will become machines (Kaplan 2012) donne un cadre pour penser cette évolution. Des formes conventionnelles sont d’abord mécanisées dans leur production (caractère typographique remplaçant les manicules manuelles) puis dans leur usage (système d’hyperliens à la base du web plus puissant, mais aussi plus contraint).

Dernière remarque : En bas à gauche de la page qui nous intéresse, un lecteur a fait un petit dessin représentant deux chiens, l’un en laisse tirant la langue et l’autre libre s’approchant.

Qui s’est permis de griffonner sur ce texte juridique ? Pourquoi dessiner deux chiens ? Valérie Hayaert a trouvé la réponse à ces interrogations. En fait, l’illustration fait ici directement référence au contenu du texte juridique. Le passage traite en effet de l’obligation pour le propriétaire d’un chien de le tenir en laisse dans les lieux publics. Même les graffitis procèdent ici d’une didactique.

Buckland, Michael. 1998. “What Is a Digital Document.” Document Numérique 2 (2).

Crystal, David. 2001. Language and the Internet. Cambridge University Press.

Pellegrin, Elisabeth. 1982. Manuscrits Latins. Bibliotheca Bodmeriana.

Robert, Pascal. 2010. Mnémotechnologies : Une Théorie Générale Critique Des Technologies Intellectuelles. Hermes Science Publications.

Posted in Uncategorized | 24 Comments »

Tags: Bodmer, commentaires, florence, glose, hyperlien, hypertexte, manuscrit, smiley