Le lancement de la Venice Time Machine, grand projet de Digital Humanities entre l’EPFL et l’université Ca’Foscari a donné lieu à plusieurs d’articles de presse et réactions sur Internet (communiqué officiel, article dans le Temps, repris également dans Le Monde) . Le projet propose une modélisation multidimensionnelle de Venise et de son empire méditerranéen. Son ambition consiste à rendre interopérables des données concernant l’histoire environnementale (évolution de la lagune), urbaine (morphogenèse de la ville), humaine (démographie et circulation) et culturelle (politique, commerce, évolution artistique). La Venice Time Machine comporte des défis en terme de numérisation (des archives immenses et très anciennes), de modélisation (reconstructions cartographiques, gestions de l’incertitude intrinsèque aux données historiques) et de muséographie (comment rendre compte de cette histoire complexe). Les équipes vénitiennes et lausannoises travailleront en étroite collaboration, dans le cadre d’un centre de recherche comme appelé Digital Humanities Venice. Nous sommes également en train de constituer un réseau international de chercheurs qui pourront collaborer à ce grand projet. Maintenant que les annonces sont passées, il est peut-être utile de revenir sur ce qui fait l’originalité de la démarche de cette machine à remonter le temps.

Peut-on construire une machine à remonter le temps ?

Au départ, il y a un rêve, celui d’adapter les outils numériques du présent à l’exploration du passé. Nous avons depuis quelques années, des outils extraordinaires pour explorer le monde sans partir de chez nous (p.e. Google Earth/Maps/Streetview). Quand nous ne voyageons pas dans l’espace physique, nous parcourons le graphe social documentant les liens et les activités de plus d’un milliard de personnes. Ces services nous donnent l’impression de vivre dans un « grand maintenant ». Le présent est devenu tellement dense que son exploration perpétuelle pour suffit à nourrir notre curiosité.

Il me semble extrêmement important de tenter de construire des outils d’exploration du temps aussi puissant que ceux qui nous permettent de voyage dans l’espace. Peut-on construire un Google Maps du passé pour nous montrer comment étaient une ville ou une région il y a plusieurs centaines d’années ? Peut-on construire un Streetview du passé pour nous montrer à quoi ressemblait une rue à cette époque ? Peut-on construire un Facebook historique documentant la vie quotidienne du passé ? Autrement dit : Peut-on construire des machines à remonter dans le temps ?

Le champignon informationnel

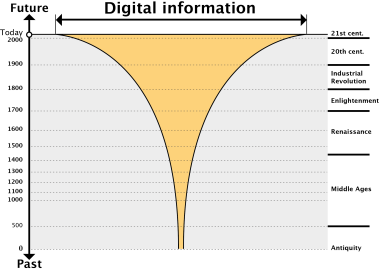

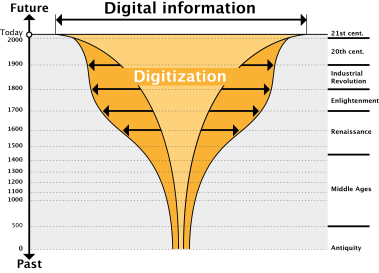

Pour répondre à cette question, il nous faut considérer ce que j’appelle « le champignon informationnel ». L’information numérique disponible sur les dix dernières années est extrêmement riche et dense. Nous pouvons représenter cet abondance par un large plateau. Pour simplifier notre raisonnement, nous dirons que plus nous reculons dans le temps plus la quantité d’information se réduit (il est possible que ce ne soit pas tout à fait vrai, certaines périodes anciennes comme l’antiquité étant potentiellement mieux documentées numériquement que certains périodes intermédiaires comme le moyen-âge). Pour pouvoir utiliser les outils du présent pour explorer le passé nous avons besoin d’une densité informationnelle comparable à celle du présent. Autrement il nous faut élargir le pied du champignon pour qu’il s’approche le plus possible d’un rectangle.

Une première manière pour réaliser cet « élargissement » consiste à numériser les archives publiques et privées. Il existe des archives télévisuelles de qualité sur une cinquantaine d’années, des archives photographiques sur plus de 100 ans, des archives de presse bien conservées sur au moins 200 ans (et souvent plus), des documents imprimés sur 500 ans, et enfin de grandes collections de manuscrits, dessins ou d’anciennes cartes. La figure ci-dessous montre symboliquement ce que nous pourrions attendre en numérisation et modélisant de telles archives. La courbe s’élargit beaucoup sur les 200 dernières années et continue, puis recommence à rétrécir jusqu’à la Renaissance. Pour des périodes plus anciennes, les sources sont, en général, globalement moins nombreuses et il est possible qu’il soit difficile de reconstituer une densité informationnelle suffisante.

Pour le pied du champignon et les données les plus anciennes, nous pouvons extrapoler à partir des données existantes et « simuler » les données manquantes. Par exemple, un carnet de bord d’un capitaine de navire vénitien nous indique bien plus qu’un itinéraire particulier, il nous informe sur les routes commerciales d’une époque. De la même manière, une gravure représentant une façade vénitienne nous décrit bien plus que ce bâtiment en particulier, mais nous renseigne sur les grammaires architecturales utilisées à cette époque particulière. Les historiens extrapolent très souvent de cette façon. Il s’agit simplement de formaliser et systématiser cette démarche.

Gestion de l’incertitude et espaces fictionnels

La gestion de l’incertitude est le coeur du défi scientifique de ce projet. Il s’agit de raisonner dans des espaces où se côtoient des incertitudes de natures très diverses (fiabilités des sources, erreurs d’interprétations, extrapolations basées sur de fausses hypothèses, erreurs dues aux procédés de numérisation). Depuis 50 ans, les sciences de l’information n’ont cessé de développer des approches pour raisonner dans des univers incertains et a priori peu prévisibles (calculs probabilistes, logique floue, apprentissage artificiel, etc.). Des méthodes qui n’ont jusque-là pas reçu suffisamment d’attention en histoire. La rencontre de ces approches formelles et des mondes historiques incertains pourrait donner lieu à de grandes découvertes.

Dans notre approche, chaque source produit ce que nous appelons un « espace fictionnel ». Ce n’est que par la « jointure » d’espaces fictionnels émanant de divers documents que nous pouvons progressivement produire un passé « probable ». Une conséquence de cette approche est qu’il n’y a évidemment pas un passé, pas une organisation de Venise ou une structuration de son empire maritime, mais de multiples mondes possibles dont nous tâchons d’évaluer la plausibilité.

Des millions de documents

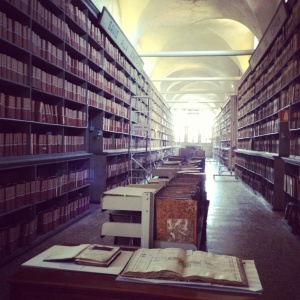

Évidemment nous n’avons pas choisi Venise au hasard. La Cité des Doges représente un cas unique dans l’histoire. Elle a très rapidement mis en place un État bureaucratique, qui deviendra vite un véritable Empire régnant sur toute la Méditerranée. La moindre délibération du Sénat ou des autres chambres était consignée, tout ce qui sortait et entrait dans la Cité, les possessions des habitants… Au total, on estime le nombre de documents exploitables à plus de 100 millions. Une personne seule ne peut évidemment pas compiler une telle somme d’informations.

Les archives d’états à Venise comportent plus 80 km de documents administratifs couvrant toute l’histoire de la Cité des Doges

Il faudra développer des techniques nouvelles pour numériser, transcrire et indexer une telle masse de documents. Nous testerons différentes approches : robots capables de manipuler avec soin les parchemins, dispositifs portables permettant une numérisation rapide et efficaces, etc. Pour transcrire ces très nombreux manuscrits, nous devrons développer de nouvelles techniques de reconnaissance de caractères couplées à des modèles des langues dans lesquelles ils sont écrits (latin, toscan, dialecte vénitien). Dans ces transcriptions, nous identifierons les noms de lieux, de personnes, les dates et progresserons pas à pas dans une caractérisation sémantique toujours plus fine.

Des millions de visiteurs

Venise c’est aussi 20 millions de touristes qui chaque année sillonnent les canaux, se perdent dans les ruelles et découvrent une cité dont, le plus souvent, ils ne savent que peu de choses. En développant de nouveaux dispositifs muséographiques, interfaces mobiles ou au contraire très large installation, nous espérons pouvoir faire mieux connaitre la fascinante histoire de ce petit peuple de pécheur qui devint maitre de la Méditerranée. Profitant de nombre du ces visiteurs nous espérons avec les équipes de Ca’Foscari mettre en place une muséographie expérimentale capable d’évaluer les succès et les échecs des dispositifs qu’elle propose. Autant d’innovations qui pourront venir nourrir d’autres musées ou d’autres villes.

Je reviendrai plus en détail sur tous ces points dans de prochains billets.